AI与MT发展历程——NMT篇

20世纪90年代初,由于人工智能领域中深度学习和神经网络的成功,机器翻译引入了这些新技术,于是统计机器翻译发展成神经机器翻译(Neural Machine Translation,简称NMT)。神经机器翻译是一种基于深度学习的翻译技术,其核心原理是利用神经网络模拟人脑神经元的连接方式来处理自然语言。NMT 通过编码器-解码器架构,将源语言文本转换为一组特征向量,然后解码器再将这些特征向量翻译为目标语言文本。这一过程中,seq2seq模型和注意力机制(Attention Mechanism)是关键技术,它们分别负责学习源语言到目标语言的映射关系和在翻译过程中关注源文本中的关键信息。NMT的优势在于能够自动学习语言的内在规律,处理复杂的语言现象,提供更高的翻译准确性和流畅度。NMT也需要大量的训练数据和计算资源,并且在模型的可解释性方面存在挑战。

下面,让我们来大致回顾一下神经机器翻译发展的大致历史进程。

远在1982年,人工神经网络(Neural Network)像雨后春笋一样迅速地发展起来,给人们带来了新的希望。人工神经网络的主要特点是信息的分布存储和信息处理的并行化,采用联结主义( connectionism)的方法,具有自组织和自学习的能力,这使得人们利用机器加工处理信息有了新的途径和方法,解决了一些使用传统的符号主义(symbolism)方法难以解决的问题 。

1987年,美国召开了第一次神经网络国际会议,宣布了神经网络这门新学科的诞生。

20世纪80年代以来,日本和欧洲各国在神经网络研制方面的投资逐步增加,进一步促进了神经网络的研究。以美国麻省理工学院布鲁克斯(R. A. Brooks)为代表的人工智能行为主义学派提出了“无需表示和推理”的智能,认为智能可以在与外界环境的交互中表现出来,表示和推理是没有必要的,并且认为,研制可以适应外界环境的“机器虫”比研制空想的“机器人”更为现实,如果使用大数据作为外界环境,就有助于推进这种“无需表示和推理”的智能。人工智能学术界充分认识到,传统的人工智能方法仅限于在模拟人类的智能活动中使用成功的经验知识来处理问题,具有很大的局限性,开始把符号机理与神经网络机理结合起来,并且引入智能体(agent)系统,在这些方面开展了一系列的研究工作。

循环神经网络(Recurrent Neural Network, RNN)的概念最早可以追溯到1982年,当时由John Hopfield提出的Hopfield网络。然而,RNN作为我们现在所熟知的形式,是在1986年由Michael I. Jordan定义并提出的Jordan网络。1990年,Jeffrey L. Elman对Jordan网络进行了简化,并采用反向传播算法(Backpropagation Through Time, BPTT)进行训练,形成了现在广泛认知的RNN模型。

卷积神经网络(Convolutional Neural Network, CNN)是一种深度学习算法,其发展始于20世纪80至90年代,主要用于计算机视觉领域,但也适用于自然语言处理等其他领域。CNN的核心优势在于其能够自动和自适应地从输入数据中学习空间层次的特征。CNN由多层结构组成,包括卷积层、池化层和全连接层等。

1997年,霍禾莱特(Hoehreiter)提出了带门限的RNN,叫做长短时记忆网络(Long Short Time Memory,简称LSTM) 。 LSTM设有输入门限(input gate)、输出门限(output gate)、遗忘门限(forget gate),具有对于自然语言中长距离依存关系建模的能力,进一步提高了RNN的性能。

2016年,谷歌公司研制了谷歌神经机器翻译系统(Google Neural Machine Translation,简称GNMT),其工作机制基于深度学习,特别是循环神经网络(RNN)和长短期记忆网络(LSTM)技术。谷歌神经机器翻译系统的横空问世将神经网络系统技术进行整合,通过使用当前最先进的训练技术,实现机器翻译质量的最大提升。其中,计算机进行翻译的时候,要利用已有的大规模的真实语料库来进行深度学习,从语料库中自动地获取语言特征和规则。大规模的语料库也就是大数据(big data),所以,GNMT是一个基于大数据的神经机器翻译系统。

现在,随着技术不断发展,许多翻译软件中随处可见语音翻译和拍照翻译的功能,这些功能是自然语言处理、语音识别、卷积神经网络等技术与翻译结合的典范。但是一些问题也应运而生:1、从日常使用经验来看,拍照翻译似乎仍不成熟,翻译准确率为何远远低于其他翻译方式?2、面对验证码时,人工智能表现为何仍远不及人类?

HU XIAOFENG

下面,让我们逐个问题进行分析。

1、拍照翻译似乎仍不成熟,翻译准确率为何远低于其他翻译方式?

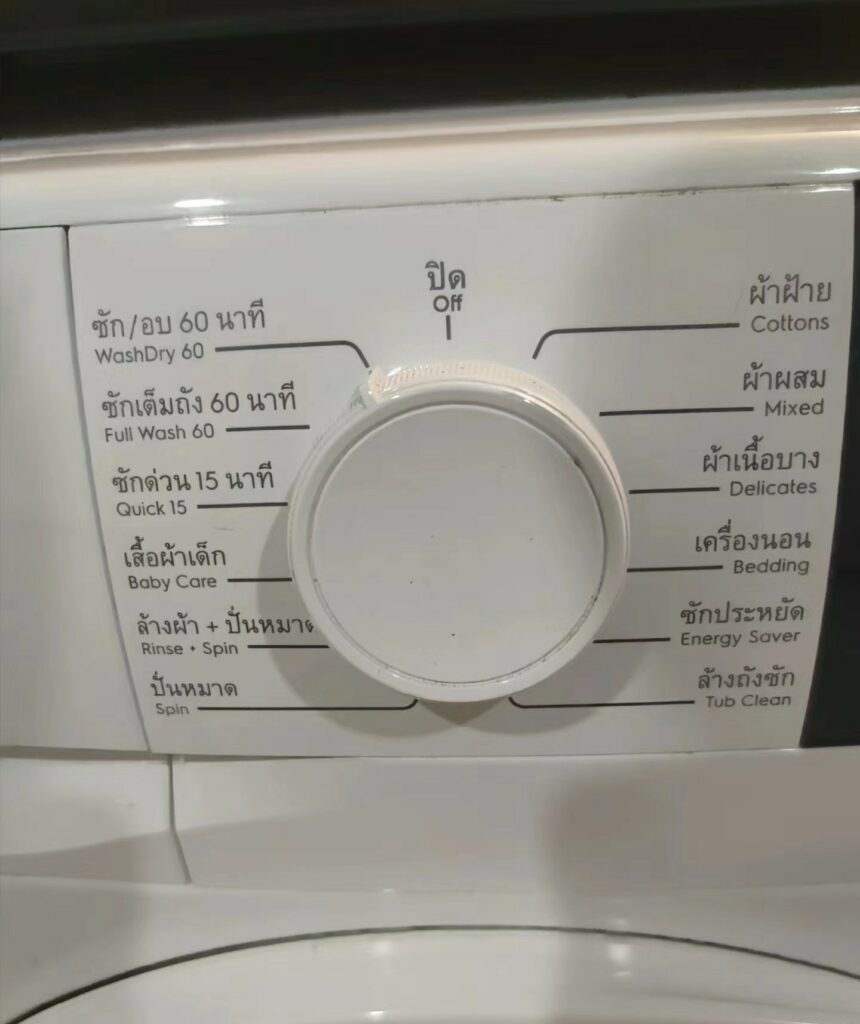

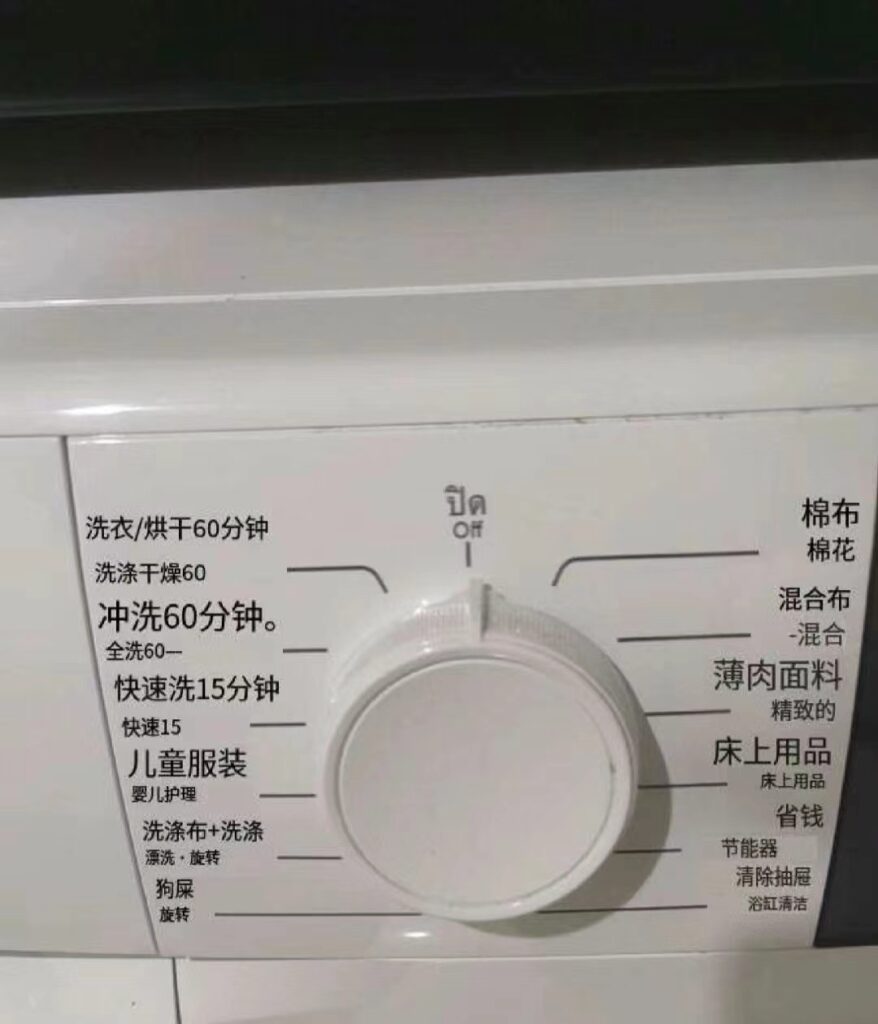

图源 小红书网友

机器翻译不比人脑,人脑可谓是一台高度精密仪器,不管是处理语音还是图片,都能达到极高的准确率,自动纠错功能也相当出色。但是对于机器而言,要进行拍照翻译工作必须先通过图片识别、文字识别,下一步才能进行翻译。而往往机器翻译从第一步“识别”便会开始出错。对于机翻工具而言,其拍照翻译功能的准确率可能受到多种因素的影响,包括但不限于以下几点:

- 图像质量:如果照片模糊、光线不足或过曝,文字可能无法被准确识别,导致翻译不准确。

- 文字角度和方向:如果拍摄时文字不是正面朝上,可能导致识别错误,影响翻译结果。

- 复杂背景:背景中的图案或颜色可能会干扰文字识别,降低准确率。

- 字体和字号:某些特殊或手写字体可能难以被识别软件准确读取。

- 语言和方言:对于非标准或方言文本,翻译软件可能没有足够的数据支持,导致翻译不准确。

- 翻译算法限制:翻译软件的算法可能无法完美处理所有语言结构和语法,特别是对于低资源语言。

- 上下文理解:拍照翻译可能缺乏对文本上下文的理解,导致翻译不符合语境。

尽管存在这些挑战,许多拍照翻译工具通过不断优化其OCR(光学字符识别)技术和翻译算法来提高准确率。此外,一些应用如“拍照翻译官”声称其文字识别准确率高达99%,并提供即时翻译和结果编辑功能以提高用户体验。然而,用户反馈和评论可能表明实际使用中可能仍会遇到准确率问题。

与直接向网页或软件中输入文本进行翻译对比,个人认为,拍照翻译的局限性很大程度上取决于识别这一步。也即,卷积神经网络的发展仍有待提高。(而如何让机器翻译在文字换行时仍翻译得又快又准,我认为需要让机器翻译先识别所有文字后做出和原先输入文字翻译一样的步骤,即输入文本,然后在整个全文的基础上进行翻译,或许会略有提高,各位读者如何认为呢?)

就我个人体验以及网上冲浪观察到底许多用户反馈而言,拍照翻译经常在文字换行时出现翻译错误,并且在字数不多的短语翻译时也常常出现离谱错误。由此可见,尽管科学家们从上个世纪就已经开始研发卷积神经网络技术,并将其与翻译结合,当今技术发展水平仍有待提高,拍照翻译质量仍有很大进步空间。

2、面对验证码时,人工智能表现为何仍远不及人类?

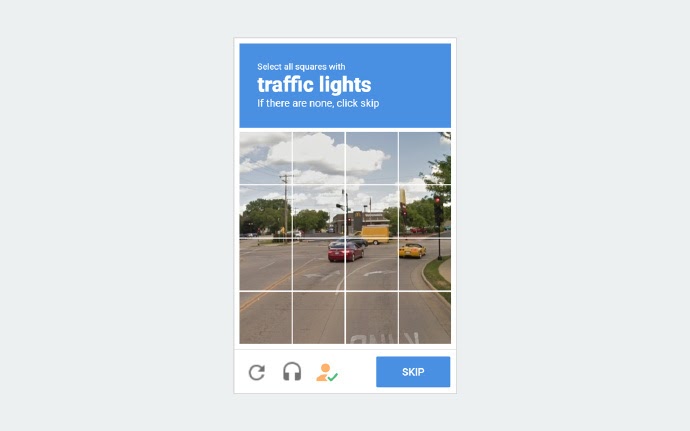

CAPTCHA是“Completely Automated Public Turing test to tell Computers and Humans Apart”的缩写,中文通常译为“完全自动化的公共图灵测试以区分计算机和人类”。CAPTCHA是一种安全性检测机制,旨在确定用户是人类还是自动化软件(俗称“机器人”或“bot”),它通过要求用户完成一个简单测试来实现这一目标,这个测试对大多数人类来说相对容易,但是对计算机自动程序则困难重重。传统CAPTCHA通常以图形验证码的形式出现,要求用户识别扭曲的文字、数字,或在一系列图像中识别特定的物体。除了这些传统形式外,还有其他类型的,如:音频CAPTCHA(为视觉障碍用户设计,播放一段含有数字或字母的音频,用户需要输入所听到的内容)、逻辑CAPTCHA(要求用户解决一个简单的数学问题或逻辑问题)、交互式CAPTCHA(拖放拼图等,要求用户执行一个简单的鼠标操作来完成挑战)。除了CAPTCHA,近年来由于验证码防线频频被突破,还诞生了reCAPTCHA。

简单来说,CAPTCHA就是我们平常耳熟能详的验证码,包括并不仅限于“你是机器人吗”、“下面数字的和是”、“请选出带有自行车的图片”、“滑动验证”等验证方式。(本人见过最讨厌的验证方式来自于NAVER,验证码居然是逻辑题,举个例子:该张账单上显示了购物内容、价格,题目问“该商品的单价是多少?”,可谓语言+智力的双重考验。当然,这对于母语者就是小菜一碟了)

几种常见的验证码类型

人类在面对此类验证码时往往觉得较为简单,那么人工智能破解验证码时表现如何呢?

2011年,斯坦福大学的计算机科学家破解了Audio Captcha(音频验证码)。

早在2013年,人工智能初创公司Vicarious就宣布,他们已利用自己的人工智能技术破解了Captcha。四年后,该公司在同行评议的学术期刊《科学》上公布了这种方法。Vicarious联合创始人迪利普·乔治(Dileep George)表示,在破解 Captcha 和 reCaptcha 时,其算法使用的方法,数据密集度并不高。乔治说,通过使用递归皮层网络(一种深度学习图像识别模型),他们用于训练算法的图像数量比其他方法少了5,000倍,同时仍然能够识别验证码系统的文本、手写的数字以及真实环境中的文字。

2014年,谷歌正式抛弃了基于文字的验证码系统,代之以“我不是机器人”按钮。这套基于人工智能的系统还包含了二次测试,用户有时需要从图集中点选所有包含猫或其他事物的图像。然而,哥伦比亚大学的三位研究人员使用深度学习技术去自动识别谷歌的reCaptcha,成功率达到了70%。研究人员同样提到,用这种方法去破解Facebook的图像验证码,取得了83.5%的准确率。

计算机视觉技术的进步让计算机得以识别图像,这也让验证码失去了当初的意义,不再能发挥作用。

“情况要么是验证码没有被破解,我们有办法区分人和计算机;要么是验证码已经被破解,我们解决了一个人工智能问题。”

(过气的)Captcha官网

再来看看GPT的表现:GPT-4为通过人机验证,试图雇人给自己打工,还骗了对方 | 机器之心 (jiqizhixin.com)相比之下,GPT的表现看起来就比较投机取巧了,但是这是否也能说明人工智能认为人工填写验证码比自己逐步分析从而破解验证码要来得更简单呢?是否可以成为人工智能仍需进一步发展的又一个佐证呢?

在这种旧验证码遭到全面冲击和破解的情况下,现阶段,验证码更多是带用户行为操作的类型,如滑动验证码,因为验证码领域与破解技术的对抗已经无法单纯靠图像来进行。

滑动验证码中主要应用用户行为分析,侧重于分析用户完成操作的行为模式。与图像识别技术相辅相成,行为分析技术通过评估操作过程中的各种行为数据——例如拖动滑块的速度、轨迹的规律性以及操作的整体时间等——来判断操作者是否为人类用户。该技术的核心在于收集和分析大量正常用户操作的数据模型,从而构建出一套判别用户性质(人类或机器)的算法。这些模型和算法能够识别出自动化脚本或机器人所无法模仿的人类特有行为特征,进而提高验证码的安全防护能力。

现阶段的现象就是,人类不断发展人工智能,试图让其完成人类视为较简单的操作任务。另一方面,又在不断提升这一项技术对于人类和机器的区分度。(总觉得像是人脑与人脑的比拼啊)

那么回到主题,为什么人工智能处理不好应用了用户行为分析的滑动验证码呢?理论上来讲行为轨迹也可以用深度学习来破解,但是这需要大量的训练样本和足够多的训练时间。

笔者认为,人工智能的数据库中应当提前获取充足的关于该用户操作行为的私密信息,这种信息无疑是被网站严格保密的,因此训练样本很难获得。此外,滑动验证码往往也规定了操作时间,当前阶段的人工智能技术还远不能在短时间内模拟用户个人行为。